Por Guilherme Pereira Pinheiro*

Depois de um longo processo legislativo, que passou por uma Comissão Temporária Interna sobre Inteligência Artificial no Brasil (CTIA), finalmente foi aprovado, no Senado Federal, o Projeto de Lei nº 2.338, de 2023, que dispõe sobre o uso da Inteligência Artificial (IA). Agora, o texto retorna para a Câmara dos Deputados para análise e deliberação.

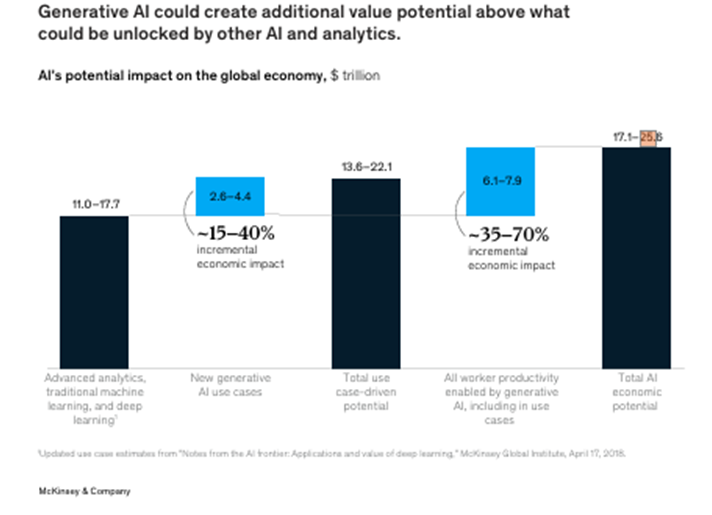

Estudos variados mostram como a IA pode impactar a economia dos países. Para a consultoria McKinsey, a adoção generalizada da IA poderia adicionar entre US$ 17,1 trilhões e US$ 25,6 trilhões ao PIB global até 2030, um aumento significativo impulsionado por avanços em produtividade e novas aplicações, como a IA generativa[1]. Ver tabela abaixo:

Outra pesquisa aponta que os gastos empresariais para adotar a inteligência artificial (IA), utilizá-la nas operações comerciais existentes e oferecer melhores produtos e serviços para clientes corporativos e consumidores terão um impacto econômico global acumulado de US$ 19,9 trilhões até 2030, impulsionando uma fatia de até 3,5% do PIB global em 2030. Ademais, 98% dos líderes empresariais consideram que a IA constitui prioridade para suas organizações[2]. Dessas projeções depreendemoso impacto decisivo que uma legislação terá no desenvolvimento e implementação dos sistemas de IA no Brasil.

O objetivo deste singelo artigo é expor, da maneira mais simples e direta possível,quais as principais obrigações e direitos previstos para cada tipo de sistema de IA presentes no Projeto de Lei nº 2.338/2023 (PL de IA). Não se trata, portanto, de uma análise crítica e exauriente, mas de elucidar, para quem não acompanha de perto o assunto, o teor da iniciativa legislativa. É mapear com maior clareza os direitos, deveres e responsabilidades dos agentes de IA previstos no texto.Não iremos aqui abordar a questão da arquitetura regulatório-institucional da proposta, que demandaria um artigo à parte.

De modo geral, a proposta estabelece normas gerais de caráter nacional para os sistemas de IA, definidos como aqueles baseados“em máquina que, com graus diferentes de autonomia e para objetivos explícitos ou implícitos, infere, a partir de um conjunto de dados ou informações que recebe, como gerar resultados, em especial previsão, conteúdo, recomendação ou decisão que possa influenciar o ambiente virtual, físico ou real”. Vale aqui uma crítica para o uso do termo ‘real’, já que tanto o ambiente físico quanto o virtual não deixam de ser reais. Ademais alguns entendem ser a definição proposta excessivamente ampla, englobando uma variedade de sistemas que podem não se enquadrar adequadamente como IA, e que tal amplitude pode levar a interpretações diversas e dificultar a aplicação prática da lei.

Primeiro, vale destacar que o PL de IA não se aplica a alguns casos específicos (art. 1º, § 1º). Por exemplo, se uma pessoa usa a IA apenas para fins pessoais e sem intenção de lucro, não há incidência da lei. O mesmo vale para sistemas criados exclusivamente para defesa nacional ou para pesquisa e testes antes do lançamento comercial, desde que respeitem as leis já existentes, como as de proteção ao consumidor e de proteção de dados pessoais. Além disso, serviços que apenas armazenam ou transportam dados para sistemas de IA também são excluídos da proposta. As exceções buscam evitar uma burocracia desnecessária e garantir que a inovação e o desenvolvimento tecnológico encontrem campo fértil para florescer.

A fim de melhor entender como os direitos e obrigações do PL de IA são ordenados, importa explicar que a proposta ordena os sistemas de IA pelo grau de risco que eles representam.

A classificação por graus de risco divide os sistemas de IA em diferentes categorias, com base no potencial impacto de dano à sociedade e aos direitos fundamentais. A proposta prevê que os desenvolvedores de sistemas de IA podem, caso desejem, realizar uma avaliação preliminarantes de colocar um sistema no mercado ou em uso para determinar o grau de risco do sistema. Tal avaliação leva em conta critérios como probabilidade de ocorrência de dano e gravidade de impactos adversos sobre pessoas ou grupos afetados. Embora a avaliação preliminar não seja obrigatória, com exceção dos sistemas de IA generativa e de propósito geral (ver abaixo), é considerada uma boa prática regulatória e pode trazer benefícios, como tratamento prioritário em procedimentos de conformidade e servir de atenuante em eventuais sanções administrativas. As autoridades setoriais podem, a qualquer tempo, solicitar a reavaliação de risco de um sistema ou exigir uma análise mais aprofundada, caso necessário.

Essa avaliação preliminar permite, assim, que os agentes de IA (desenvolvedores, distribuidores e aplicadores) classifiquem os sistemas antes de sua introdução no mercado, levando em consideração critérios como gravidade e probabilidade de impactos adversos.

Quanto ao risco, o PL de IA classifica os sistemas de IA como de alto risco, de risco excessivo ou aqueles que não se enquadram em nenhuma das duas classificações.

De alto risco são os sistemas de IA que podem afetar significativamente a vida das pessoas, como IA aplicada na segurança de infraestruturas críticas (trânsito, energia, água), em decisões educacionais, em decisões de recrutamento e emprego, na concessão de benefícios públicos, serviços médicos, justiça e identificação biométrica. Em tais hipóteses, há obrigações de explicabilidade das decisões, supervisão humana e direito de contestação.

Os sistemas de IA de alto risco independem, como regra, de autorização prévia do Poder Público para disponibilização ao público. Mas a autoridade competente poderá atualizar a lista e definir novas categorias de alto risco, levando em consideração o potencial impacto sobre os direitos fundamentais.A proposta prevê que um Sistema Nacional de Regulação e Governança de Inteligência Artificial (SIA) estabeleça critérios para categorizar os sistemas de IA como de alto risco e determine novas situações em que a classificação de alto risco se aplique, levando em conta a possibilidade e intensidade dos efeitos negativos a impactar os usuários.

Já o risco excessivocontempla sistemas de IA que são expressamente proibidos, pois representariam ameaças intoleráveis, como a manipulação do comportamento das pessoas para fins prejudiciais, classificação social pelo poder público (à semelhança do sistema de crédito social da China, por exemplo) e sistemas autônomos de armas.

Vejamos agora quais são os direitos,previstos no PL, que incidem sobre cada um dos tipos de sistema de IA. Sobre todo e qualquer sistema,independentemente do grau de risco, deve-se contemplar o direito à informação[3] e o direito à privacidade e proteção de dados pessoais[4]. Aliás, qualquer sistema de IA é obrigado a informar a comunicar às autoridades a ocorrência de eventual grave incidente de segurança.

Caso o sistema de IA seja destinado a grupos vulneráveis, como crianças, idosos e pessoas com deficiência, há deveres específicos de transparência, ou seja, os sistemas devem ser desenvolvidos, implementados e utilizados de forma que os usuários possam compreender plenamente seu funcionamento. Nesses casos, a linguagem também deve ser acessível e adequada, a fim de que a comunicação seja simples, clara e apropriada para a capacidade cognitiva dos usuários vulneráveis.

É obrigação, ainda, de qualquer sistema de IA, a remuneração dos titulares de conteúdos protegidos por direitos autorais e conexos utilizados para mineração, treinamento e desenvolvimento de IA.

Já os usuários afetados por sistemas de IA de alto risco têm direitos específicos garantidos pelo PL de IA, que visam proteger sua autonomia, transparência e possibilidade de contestação. Dentre esses direitos estão os de: (i) explicação sobre decisões automatizadas, de entender como e por que um sistema de IA tomou uma decisão, recomendação ou previsão que o afete; (ii)contestação e revisão de decisões, nos casos em quese discorde de uma decisão automatizada; (iii) supervisão humana das decisões, uma vez que decisões tomadas por sistemas de IA de alto risco devem ser passíveis de revisão, especialmente se impactarem direitos fundamentais; (iv) direito à transparência e acesso às informações do sistema, permitindo que as pessoas saibam quando estão interagindo com IA e como suas decisões são influenciadas.

Ademais, há uma série de obrigações de governança impostas para sistemas de IA de alto risco, compartilhadas entre desenvolvedores e aplicadores(aqueles que utilizam a IA em seu próprio nome ou benefício) dos sistemas de IA.

Aplicadores devem documentar todas as etapas do ciclo de vida da IA, realizar testes para garantir sua confiabilidade, registrar o grau de supervisão humana envolvida e adotar medidas para evitar discriminação. Devem, também, disponibilizar informações adequadas para permitir a interpretação dos resultados, respeitando o sigilo comercial e industrial. Os desenvolvedores, por sua vez,são obrigados a manter registros das medidas de governança adotadas, garantir a rastreabilidade do funcionamento da IA, realizar testes de segurança e viabilizar o acesso a informações essenciais sobre o sistema, além de prevenir vieses discriminatórios e assegurar a transparência em suas práticas de gestão.

Vale notar que os chamados distribuidores, ou seja, aqueles que disponibilizam e distribuem sistema de IA para que terceiro o aplique, será responsável por verificar a adoção de todas as medidas de governança, antes que o produto entre no mercado.

Outra obrigação para sistemas de IA de alto risco é fazer uma avaliação de impacto algorítmico dos sistemas de IA. A avaliação conterá análise dos efeitos sobre os direitos fundamentais, a indicação de estratégias para prevenir, reduzir e corrigir possíveis impactos deletérios da tecnologia, além de sugerir ações para maximizar os benefícios proporcionados pelo sistema de IA.

Quanto à responsabilidade civil, depois de muitas idas e vindas, o PL decidiu manter as regras já existentes, prevendo apenas a inversão do ônus da prova nas hipóteses de hipossuficiência ou onerosidade excessiva.

Há, outrossim, obrigações específicas para os sistemas de propósito geral[5] e de IA generativa[6], como o ChatGpt ou o DeepSeek, que criam novos conteúdos, como textos, imagens, vídeos, códigos e até música, a partir de padrões aprendidos em grandes conjuntos de dados e IA. Esses sistemas representam risco maior pois utilizam modelos de aprendizado profundo, como redes neurais, para produzir respostas ou gerar conteúdos que não são meras extrações de dados, mas criações novas.

Para os sistemas de IA generativa e de propósito geral, qualquer conteúdo sintético gerado ou modificado por IA deverá conter identificador que permita verificar sua autenticidade e origem, conforme regulamentação futura. Além disso, cabe aos desenvolvedores manterem documentação detalhada sobre a criação e uso desses sistemas, com avaliações preliminares para identificar riscos, incluindo riscos sistêmicos, e aplicando medidas para reduzir impactos negativos e maximizar os positivos.

A fim de reforçar a transparência, será exigida, também, a publicação de resumo dos dados utilizados no treinamento dos modelos, para maior clareza sobre a base de conhecimento utilizada. Outra exigência importante é a adoção de padrões de eficiência energética e sustentabilidade, assegurando que os modelos sejam desenvolvidos com menor consumo de energia e impacto ambiental reduzido. Por fim, quando um sistema generativo for utilizado como base para outros serviços, como via API[7], os desenvolvedores devem garantir cooperação na cadeia de valor, colaborando com os demais agentes para mitigar riscos e assegurar o cumprimento da legislação.

Finalmente, no caso de existir um sistema de IA generativa e de propósito geral com risco sistêmico[8], deve-se garantir que os desenvolvedores, de acordo com o PL de IA: (i) descrevam detalhadamente o modelo de IA utilizado e seu propósito; (ii) documentem os testes e análises realizados, permitindo a identificação e gestão de riscos previsíveis, dentro dos limites técnicos viáveis, incluindo os riscos que não possam ser mitigados; (iii) publiquem um resumo dos dados utilizados no treinamento do sistema, conforme definido na regulamentação; (iv) otimizem o consumo de energia e recursos, reduzam desperdícios e aumentem a eficiência energética e global do sistema.

Sem pretender esgotar o assunto, vemos que a proposta é bastante detalhada e percuciente quanto às obrigações a serem exigidas dos agentes que lidam com sistemas de IA, atraindo, por isso, muitas críticas. Disponibilizamos, ao final do artigo, um quadro resumido e não exaustivo com as referidas obrigações.

De fato, uma legislação excessivamente intervencionista no campo da IA pode gerar impactos negativos significativos para a inovação, para os investimentos e ao desenvolvimento tecnológico, criando barreiras à entrada, especialmente para startups e pequenas empresas, que muitas vezes não possuem os recursos necessários para cumprir exigências complexas de conformidade.

A burocracia e os altos custos regulatórios podem afastar investimentos, levando empresas a desenvolverem e testarem suas tecnologias em países com ambientes regulatórios mais flexíveis e favoráveis à inovação. O resultado seria a desaceleração do avanço tecnológico, reduzindo a competitividade do país no setor global de IA e restringindo o acesso a novas soluções que poderiam beneficiar a sociedade.

O modelo regulatório mais denso de IA, abraçado pela União Europeia, teve como motivação estratégica, entre outros motivos, a assunção de uma “liderança regulatória”, com objetivo de posicionar o bloco europeu como um “empreendedor de política regulatória”[9]. Esta pode não ser a melhor estratégia para o Brasil. Portanto, é essencial que a regulação equilibre a proteção de direitos fundamentais e a segurança com a flexibilidade necessária para fomentar a inovação e o desenvolvimento sustentável da tecnologia.

Obrigações para cada tipo de IA no PL 2238/2023

| Tipo de IA | Obrigações Principais |

| IA de Alto Risco | Supervisão humana, explicabilidade, mitigação de vieses, documentação detalhada, testes de segurança, transparência e direito de contestação. |

| IA de Risco Excessivo | Proibição total, pois apresentam riscos graves, como manipulação comportamental, classificação social pelo Estado e armas autônomas. |

| IA de Propósito Geral | Descrição do modelo, documentação de testes, mitigação de riscos, conformidade com LGPD, publicação de resumo dos dados de treinamento. |

| IA Generativa | Identificação de conteúdo sintético, transparência nos dados de treinamento, eficiência energética, governança de riscos, cooperação na cadeia de valor. |

| IA Generativa de Alto Risco | Além das exigências da IA generativa, devem documentar riscos não mitigáveis, otimizar eficiência energética e detalhar impactos sistêmicos. |

[1]Mckinsey Global Institute. The Economic Potential of Generative AI: The Next Productivity Frontier. McKinsey & Company, 2024. Disponível em: https://www.mckinsey.com. Acesso em: 5/02/2025 fev. 2025.

[2] IDC. The Global Impact of Artificial Intelligence on the Economy and Jobs. International Data Corporation, 2024. Disponível em: https://www.idc.com. Acesso em 05/02/2025.

[3] O usuário (chamado de aplicador no PL) tem direito de saber quando está interagindo com um sistema de IA e a informação deve ser acessível, gratuita e de fácil compreensão.

[4] Daqui decorre que o uso de IA deve respeitar a Lei Geral de Proteção de Dados Pessoais (LGPD).

[5] Segundo o PL de IA, o sistema de IA de propósito geral é aquele desenvolvido a partir de um modelo treinado com grandes volumes de dados, apto a desempenhar diversas funções distintas e atender a múltiplas finalidades, inclusive aquelas para as quais não foi originalmente projetado ou treinado, podendo ser incorporado a diferentes sistemas ou aplicações.

[6] Isso, claro, além das obrigações gerais a todos os tipos de sistemas de IA, como garantir a proteção de dados e privacidade, evitar vieses discriminatórios, assegurar a transparência e explicabilidade, por exemplo.

[7]Sigla para Application Programming Interface, que significa Interface de Programação de Aplicativos. É um conjunto de instruções, padrões e rotinas de programação que permite a comunicação entre diferentes aplicativos.

[8] No contexto do PL de IA, o risco sistêmico refere-se a possíveis impactos negativos resultantes do uso de um sistema de inteligência artificial de propósito geral e generativa, com consequências relevantes para os direitos fundamentais, tanto individuais quanto coletivos.

[9] Justo-Hanani, Ronit. The Politics of Artifical Intelligence Regulation and Governance Reform in the European Union. Policy Sciences, vol. 55, 2022 p. 142. Disponível em: https://doi.org/10.1007/s11077-022-09452-8 . Acesso em 11/02/2025.

* Guilherme Pereira Pinheiro é advogado, professor do Mestrado em Direito do IDP e consultor legislativo na Câmara dos Deputados.